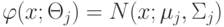

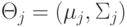

Верно ли, что если классы имеют нормальные функции правдоподобия, то байесовское решающее правило имеет квадратичную разделяющую поверхность.

(Отметьте один правильный вариант ответа.)

Варианты ответа

Нет

Да(Верный ответ)