Теория и практика параллельных вычислений - ответы

Количество вопросов - 250

При разработке параллельного алгоритма умножения матриц, основанного на ленточной схеме разделения данных, может быть использован подход:

За основу организации параллельных вычислений при реализации метода сопряженных градиентов выбирается:

В обобщенном алгоритме быстрой сортировки в дополнение к обычному методу быстрой сортировки предлагается:

В результате выполнения одной итерации параллельного алгоритма быстрой сортировки исходное множество процессоров разделяется на:

Каковы причины значительного снижения полезной вычислительной нагрузки для процессоров при организации волновых вычислений в системах с распределенной памятью?

При выполнении параллельного алгоритма, основанного на ленточной схеме разделения данных, основной коммуникационной операцией является:

С ростом числа процессоров, наибольшее ускорение демонстрирует:

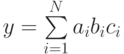

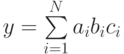

Пусть есть задача вычисление суммы следующего вида  . Пусть N = 4 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления:

. Пусть N = 4 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления:

Из представленных в лекции алгоритмов, лучшей масштабируемостью обладает:

Базовая операция "сравнить и разделить" отличается от операции "сравнить и переставить":

Под коллективными операциями в MPI понимаются:

При выборе способа разделения вычислений при прочих равных условиях нужно отдавать предпочтение:

Рассмотрение графа "подзадачи – сообщения" концентрирует внимание на вопросах:

Эксперименты в режиме имитации возможно проводить:

Задача поиска всех кратчайших путей обычно формулируется как:

Режим передачи по готовности может быть использован только если:

Под параллельной программой в рамках MPI понимается:

Управление распределением нагрузки для процессоров необходимо:

В чем состоят необходимые условия для возможности организации параллельных вычислений:

Рассмотрим задачу поиска решения системы линейных уравнений. Пусть размер матрицы системы линейных уравнений 100x100. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какое в этом случае достигается теоретическое ускорение:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какое в этом случае достигается теоретическое ускорение:

Какие проблемы параллельного программирования являются общими для систем с общей и распределенной памятью?

Метод покоординатного разбиения для решения задачи оптимального разделения графов отличается от метода бинарного деления тем, что:

Двоичный код Грея используется для определения соответствия между:

Время начальной подготовки (tн) характеризует:

Пусть есть задача вычисления суммы следующего вида  . Пусть N = 8 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равна эффективность при использовании восьми вычислительных элементов:

. Пусть N = 8 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равна эффективность при использовании восьми вычислительных элементов:

В методах покоординатной маршрутизации поиск путей передачи данных осуществляется:

Для эффективного выполнения параллельного алгоритма умножения матриц, основанного на ленточной схеме разделения данных, необходимо, чтобы процессоры вычислительной системы были организованы в топологию:

Какая коммуникационная операция используется в параллельном алгоритме умножения матрицы на вектор, основанном на блочном разделении матрицы, для получения блоков результирующего вектора на процессорах, составляющих одну строку процессорной решетки?

Какие режимы передачи данных поддерживает система имитационного моделирования ПараЛаб:

Распределенные вычислительные системы:

Кластерные вычислительные системы:

Под мультикомпьютером понимается:

Типовые топологии сети передачи данных определяются:

Какая из приведенных в лекции топологий (при одинаковом количестве процессоров) обладает наименьшей стоимостью:

В модели вычислений вершинами графа являются:

Стоимость вычислений - это:

При вычислении общей суммы последовательности числовых значений стоимостно-оптимальным алгоритмом является:

Пусть есть задача вычисления суммы следующего вида  . Пусть N = 6 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равна стоимость вычислений при использовании восьми вычислительных элементов:

. Пусть N = 6 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равна стоимость вычислений при использовании восьми вычислительных элементов:

Пусть в решаемой задаче последовательная часть составляет четыре единицы времени, а часть, допускающая линейное распараллеливание, шесть единицы времени. Если использовать закон Амдаля, сколько потребуется процессоров для достижения ускорения в два раза:

Метод покоординатной маршрутизации в приложении к топологии типа гиперкуб состоит:

Основной набор параметров, описывающих время передачи данных, состоит из следующего набора величин:

При использовании метода передачи сообщений:

Задача редукции определяется в общем виде как:

Соседние вершины в нумерации кода Грея имеют:

Для кластерных систем характерна:

Масштабирование разрабатываемого параллельного алгоритма это процесс:

Граф "процессы – каналы" используется:

Для снижения сложности моделирования и анализа параллельных методов операции передачи и приема данных считаются выполняющимися:

Выбор способа разделения вычислений на независимые части основывается:

В статической схеме передачи данных:

Этап распределения подзадач между процессорами является избыточным, если:

Для организации параллельных вычислений в вычислительных системах с распределенной памятью необходимо:

Под коммуникатором в MPI понимается:

Процессы, между которыми выполняется передача данных:

В синхронном режиме передачи завершение функции отправки сообщения происходит:

Функция блокирующего ожидания завершения одного обмена в MPI называется:

Коллективные операции MPI:

Обобщенная передача данных от всех процессов всем процессам может быть описана как:

Протяженность производного типа в MPI это:

H-векторный и H-индексный способы создания данных отличаются от векторного и индексного способов тем, что:

MPI поддерживает топологии вида:

Какие способы распределения элементов матрицы между процессорами вычислительной системы изложены в данной лекции?

Какая коммуникационная операция используется при выполнении параллельного алгоритма умножения матрицы на вектор, основанного на разделении матрицы на вертикальные полосы?

Для эффективного выполнения параллельного алгоритма умножения матрицы на вектор, основанного на разделении матрицы на вертикальные полосы, необходимо, чтобы процессоры вычислительной системы были объединены в топологию:

Какие алгоритмы обладают наилучшими теоретическими показателями ускорения и эффективности (в случае, когда не учитываются затраты на передачу данных между процессорами):

Рассмотрим задачу перемножения матрицы на вектор. Пусть размер перемножаемой матрицы 100x100. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки, чему будет равна теоретическая стоимость при использовании 2 процессоров:

нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки, чему будет равна теоретическая стоимость при использовании 2 процессоров:

Пусть перед программистом поставлена задача перемножения матрицы на вектор. Размер перемножаемой матрицы 100x100. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на блоки (количество блоков по строкам и по строкам равно и равно

нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на блоки (количество блоков по строкам и по строкам равно и равно  , где p – количество процессоров), чему будет равно теоретическое ускорение при использовании 16 процессоров:

, где p – количество процессоров), чему будет равно теоретическое ускорение при использовании 16 процессоров:

Какие схемы разделения данных используются при разработке параллельных алгоритмов умножения матриц?

С ростом числа процессоров, наибольшее ускорение демонстрируют:

Рассмотрим задачу перемножения матриц. Пусть размер перемножаемой матрицы 100x100. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на ленты, чему будет равно теоретическое ускорение при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на ленты, чему будет равно теоретическое ускорение при использовании 4 процессоров:

Рассмотрим задачу перемножения матриц. Пусть размер перемножаемой матрицы 200x200. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Фокса, чему будет равна теоретическая эффективность при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Фокса, чему будет равна теоретическая эффективность при использовании 4 процессоров:

Какая схема разделения данных используется при реализации параллельного алгоритма Гаусса?

На каждой итерации прямого хода алгоритма Гаусса для нахождения ведущей строки используется

За основу организации параллельных вычислений при реализации метода сопряженных градиентов выбирается параллельное выполнение операции умножения матрицы на вектор, потому что:

Рассмотрим задачу поиска решения системы линейных уравнений. Пусть размер матрицы системы линейных уравнений 100x100. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какая в этом случае достигается теоретическая эффективность:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какая в этом случае достигается теоретическая эффективность:

Рассмотрим задачу поиска решения системы линейных уравнений. Пусть размер матрицы системы линейных уравнений 20x20. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какая в этом случае достигается теоретическая стоимость параллельного алгоритма:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какая в этом случае достигается теоретическая стоимость параллельного алгоритма:

Внутренняя сортировка это:

Базовая операция "сравнить и переставить" состоит из:

Общее число итераций параллельного алгоритма чет-нечетной сортировки при использовании p процессоров равно:

Параллельный вариант алгоритма Шелла состоит в следующем:

При надлежащем выборе ведущих элементов в алгоритме быстрой сортировки исходный массив данных оказывается упорядоченным после выполнения:

Три схемы распараллеливания алгоритма быстрой сортировки различаются:

Один из этапов параллельного алгоритма быстрой сортировки состоит том, что:

Для поддержки упорядоченности в ходе выполнения алгоритма обобщенной быстрой сортировки процессоры должны выполнять:

Сложность последовательного алгоритма Флойда имеет порядок:

При горизонтальном разбиении матрицы исходных данных на каждой итерации алгоритма Флойда потребуется передавать между подзадачами:

Охватывающим деревом (или остовом) неориентированного графа называется:

Трудоемкость нахождения МОД характеризуется:

Задача оптимального разделения графа состоит в разбиении вершин графа на непересекающиеся подмножества:

Для разбиения графа на k частей в методе бинарного деления для решения задачи оптимального разделения графов необходимо выполнить:

На одном из этапов метода покоординатного разбиения для решения задачи оптимального разделения графов:

Основное отличие комбинаторных алгоритмов от геометрических методов, применяемых для решения задачи оптимального разделения графов, заключается:

При разработке параллельных алгоритмов решения дифференциальных уравнений в частных производных за основу выбирается разделение данных, потому что:

Каким образом обеспечивается балансировка вычислительной нагрузки процессоров для параллельных алгоритмов для систем с общей памятью,?

Чем определяется эффективность параллельных вычислений?

В чем состоит первая проблема, которую приходится решать при организации параллельных вычислений на системах с распределенной памяти?

Какие механизмы передачи данных могут быть задействованы?

К числу параметров вычислительной системы в системе ПараЛаб относятся:

В каком из режимов можно провести вычислительный эксперимент?

При построении графических зависимостей для экспериментов, проведенных в режиме удаленного доступа к параллельной вычислительной системы, используется:

Какие топологий сети не поддерживает система имитационного моделирования ПараЛаб:

На каких топологиях сети в системе ПараЛаб не реализованы алгоритмы обработки графов:

Помимо выполнения экспериментов в режиме имитации, в системе ПараЛаб предусмотрена возможность проведения реальных экспериментов в режиме удаленного доступа к вычислительному кластеру. Какие возможны операции после выполнения реальных параллельных вычислений:

При выполнении параллельного алгоритма, основанного на разделении данных на горизонтальные полосы, сбор данных полученных результатов выполняется при помощи:

Операция широковещательной рассылки данных это:

Базовая операция "сравнить и переставить" обычно используется в:

Какие из перечисленных ниже классы задач поддерживает система имитационного моделирования ПараЛаб:

Комбинаторные методы решения задачи оптимального разделения графов обычно обеспечивают:

Разработка параллельных алгоритмов включает в себя этапы:

При проведении серии экспериментов системой ПараЛаб может автоматически варьироваться:

Трудоемкость параллельного алгоритма чет-нечетной сортировки оценивается выражением:

Каскадная схема используется для:

Для эффективного выполнения алгоритма Фокса необходимо, чтобы процессоры вычислительной системы были организованы в топологию:

В рамках системы ПараЛаб какие допускаются схемы выполнения вычислений при проведении экспериментов:

Для того чтобы выбрать ведущий элемент в параллельном алгоритме быстрой сортировки выполняются следующие действия:

Один из возможных способов агрегации вычислений для увеличения эффективности параллельного алгоритма Флойда состоит:

В методе передачи пакетов:

Рассмотрим задачу перемножения матрицы на вектор. Пусть размер перемножаемой матрицы 100x100. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки чему будет равно теоретическое ускорение при использовании 2 процессоров:

нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки чему будет равно теоретическое ускорение при использовании 2 процессоров:

Основным показателем успешности выполнения этапа распределения подзадач между процессорами является:

Рассмотрим задачу перемножения матриц. Пусть размер перемножаемой матрицы 100x100. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать алгоритм Кеннона, чему будет равно теоретическое ускорение при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать алгоритм Кеннона, чему будет равно теоретическое ускорение при использовании 4 процессоров:

При разработке параллельных алгоритмов для матричных вычислений за основу выбирается разделение данных, потому что:

Пусть есть задача вычисления произведения всех элемента вектора  . Пусть N = 6 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равно ускорение при использовании неограниченного числа вычислительных элементов:

. Пусть N = 6 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равно ускорение при использовании неограниченного числа вычислительных элементов:

Для эффективного выполнения параллельного алгоритма умножения матрицы на вектор, основанного на разделении матрицы на горизонтальные полосы, необходимо, чтобы процессоры вычислительной системы были объединены в топологию:

В рассматриваемой учебной задаче по решению задачи Дирихле при использовании разделенной памяти, какие возможны способы разделения данных?

Алгоритмы маршрутизации определяют:

Номер процесса в рамках MPI именуется:

Для распределения вычислений между процессорами в вычислительных системах с распределенной памятью необходимо:

Режим разделения времени:

Под кластером обычно понимается:

В основе классификации вычислительных систем в систематике Флинна используются:

Среди рассмотренных в лекции типовых топологий приведены:

Какая из приведенных в лекции топологий (при одинаковом количестве процессоров) обладает наименьшим диаметром:

Ускорение параллельных вычислений – это:

Пусть в решаемой задаче последовательная часть составляет четыре единицы времени, а часть, допускающая линейное распараллеливание, шесть единицы времени. Если использовать закона Густавсона-Барсиса, сколько потребуется процессоров для достижения ускорения в два раза (результат округлите в большую сторону):

Метод передачи пакетов в большинстве случаев приводит к:

Для рассылки от одного процессора всем остальным процессорам сети при использовании топологии типа гиперкуб достаточно (N=log2p):

Способы логического представления (отображения) топологий характеризуются следующими тремя основными характеристиками:

Соседние вершины в кольцевой топологии отображаются кодом Грея:

В модели Хокни используются параметры:

Распределение подзадач между процессорами должно быть выполнено таким образом, чтобы:

Граф "подзадачи – сообщения" представляет собой:

Канал передачи данных можно рассматривать как:

Для локальной схемы передачи данных характерно:

Все данные для передачи в качестве сообщения MPI описываются с помощью триады:

Сигнатурой производного типа в MPI именуется:

При выполнении параллельного алгоритма, основанного на разделении матрицы на горизонтальные полосы, сбор данных результирующего вектора выполняется при помощи:

Пусть перед программистом поставлена задача перемножения матрицы на вектор. Размер перемножаемой матрицы 100x100. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на блоки (количество блоков по строкам и по строкам равно и равно

нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на блоки (количество блоков по строкам и по строкам равно и равно  , где p – количество процессоров), чему будет равно теоретическая эффективность при использовании 4 процессоров:

, где p – количество процессоров), чему будет равно теоретическая эффективность при использовании 4 процессоров:

Какая схема разделения данных используется при разработке параллельных алгоритмов Фокса и Кэннона?

Какие коммуникационные операции используются при выполнении параллельного алгоритма Фокса?

Какое расположение вектора правых частей и вектора неизвестных используется при реализации параллельного алгоритма Гаусса:

При выполнении параллельного алгоритма Гаусса основными коммуникационными операциями являются:

При реализации параллельного алгоритма для метода сопряженных градиентов вычисления над векторами дублируются на всех процессорах для того, чтобы:

Задача сортировки данных обычно формулируется как:

Алгоритм быстрой сортировки основан на:

Оптимальная стратегия выбора ведущего элемента при применении параллельных алгоритмов быстрой сортировки состоит в выборе такого значения ведущего элемента, при котором:

Минимально охватывающим деревом называется:

Количество выполняемых операций при определении номера ближайшей вершины до охватывающего дерева и корректировке расстояний после расширения МОД ограничивается сверху величиной:

Для разбиения графа на k частей в методе бинарного деления для решения задачи оптимального разделения графов необходимо:

С какими проблемами сталкивается программист, разрабатывая параллельные программы для систем с общей памятью?

Какой способ наиболее эффективен при подсчете общей для всех процессоров погрешности вычислений, которые используются в параллельной реализации метода сеток на системах с распределенной памятью?

За счет чего увеличивается число передач данных между процессорами при блочном представлении сетки области расчетов на системах с распределенной памятью?

Какие достоинства имеет синхронный механизм передачи сообщений?

Для постановки задачи в системе ПараЛаб необходимо выбрать:

При анализе результатов проведенных экспериментов пользователю предоставляется возможность:

В рамках системы ПараЛаб какие присутствуют средства для детального изучения и исследования параллельных алгоритмов решения сложных вычислительных задач:

Процессы параллельной программой в рамках MPI:

При индексном способе новый производный тип создается как:

Для эффективного выполнения алгоритма Кэннона необходимо, чтобы процессоры вычислительной системы были организованы в топологию:

В коллективных операциях передачи данных обязаны принимать участие:

Задача разделения вычислительной сети, на которую разбивается область обрабатываемых данных, между процессорами может быть сведена:

Применение неблокирующего способа выполнения обменов позволяет:

В модифицированной каскадной схеме:

При асинхронном способе взаимодействия участники взаимодействия:

При реализации параллельного алгоритма Гаусса рекомендуется использовать ленточную циклическую схему разделения данных, потому что

Завершение функции MPI_Send означает, что:

Пусть в решаемой задаче последовательная часть составляет четыре единицы времени, а часть, допускающая линейное распараллеливание, шесть единицы времени. Если использовать закон Амдаля, какая достигается эффективность, если используются три вычислительных элемента:

Какие способы разделения элементов матрицы между процессорами вычислительной системы используются для разработки параллельных алгоритмов умножения матрицы на вектор?

Какие алгоритмы обладают наилучшими теоретическими показателями ускорения и эффективности (в случае, когда не учитываются затраты на передачу данных между процессорами):

Показатели ускорения и эффективности параллельного алгоритма Прима имеют вид (без учета затрат на передачу данных):

К основным преимуществам кластерных вычислительных систем относится:

Операцию редукции данных MPI_Reduce можно описать:

Показатели ускорения и эффективности параллельного алгоритма Флойда имеют вид (без учета затрат на передачу данных):

Равновесность подмножеств вершин в задаче оптимального разделения графа:

На каждой итерации обратного хода метода Гаусса используется

Какую компьютерную систему можно отнести к суперкомпьютерам:

Общее наименьшее количество итераций параллельного алгоритма Шелла равно:

Какие способы распределения данных между процессорами вычислительной системы изложены в данной лекции?

Рассмотрим задачу перемножения матрицы на вектор. Пусть размер перемножаемой матрицы 100x100. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки чему будет равно ускорение при использовании 4 процессоров:

нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки чему будет равно ускорение при использовании 4 процессоров:

При выполнении алгоритма обобщенной быстрой сортировки в качестве ведущего элемента обычно выбирается:

В модели вычислений дуги графа определяют:

Прием сообщений при помощи функции MPI_Recv может быть осуществлен:

Пусть есть задача вычисления произведения всех элементов вектора  . Пусть N = 10 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления:

. Пусть N = 10 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления:

На основании результатов экспериментов, представленных в лекции, можно сказать, что наибольшее ускорение демонстрирует:

Топология типа тор в MPI является частным видом топологии типа:

Минимально необходимый набор операций для организации информационного взаимодействия между процессорами в вычислительных системах с распределенной памятью включает в себя только:

К числу суперкомпьютеров относятся:

Какая из приведенных в лекции топологий (при одинаковом количестве процессоров) обладает наибольшей связностью:

Эффективность параллельных вычислений – это:

Циклический q-сдвиг, это операция, при которой:

Указание используемого коммуникатора является:

Прием сообщения при помощи функции MPI_Recv может быть инициирован:

При векторном способе новый производный тип создается как:

С ростом числа процессоров, согласно теоретической оценке, наибольшее ускорение демонстрирует:

Можно ли утверждать, что представленные в лекции алгоритмы обладают идеальными теоретическими показателями ускорения и эффективности (в случае, когда не учитываются затраты на передачу данных между процессорами):

Рассмотрим задачу поиска решения системы линейных уравнений. Пусть размер матрицы системы линейных уравнений 100x100. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какое в этом случае достигается теоретическое ускорение:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какое в этом случае достигается теоретическое ускорение:

Нижняя оценка необходимого количества операций для упорядочивания набора из n значений определяется выражением:

Основными отличиями параллельного алгоритма Шелла от метода чет-нечетной перестановки являются:

При применении параллельных алгоритмов быстрой сортировки одним из основных моментов является:

Задача нахождения МОД формулируется как:

Вычислительный эксперимент в системе ПараЛаб – это:

На каких топологиях сети в системе ПараЛаб реализованы алгоритмы перемножения матриц:

Для параллельных алгоритмов для систем с общей памятью при проведении вычислительных экспериментов может наблюдаться сверхлинейное ускорение. Каковы возможные причины достижения этого эффекта?

Трудоемкость алгоритма пузырьковой сортировки оценивается выражением:

В декартовой топологии множество процессов представляется в виде:

При построении графических зависимостей для экспериментов, проведенных в режиме имитации, используются:

Под мультипроцессором понимается:

Пусть есть задача вычисление суммы следующего вида  . Пусть N = 8 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления:

. Пусть N = 8 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления:

Производным типом данных в MPI называется:

Число итераций параллельного алгоритма Флойда равно:

На каких топологиях сети в системе ПараЛаб реализована быстрая сортировка:

Из представленных в лекции алгоритмов, лучшей масштабируемостью обладает:

Топология полный граф сети кластерной вычислительной системы может иметь ограничения на:

Рассмотрим задачу перемножения матриц. Пусть размер перемножаемой матрицы 100x100. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Фокса, чему будет равно теоретическое ускорение при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Фокса, чему будет равно теоретическое ускорение при использовании 4 процессоров:

Рассмотрим задачу перемножения матриц. Пусть размер перемножаемой матрицы 200x200. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на ленты, чему будет равна теоретическая эффективность при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на ленты, чему будет равна теоретическая эффективность при использовании 4 процессоров:

Рассмотрим задачу поиска решения системы линейных уравнений. Пусть размер матрицы системы линейных уравнений 200x200. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какая в этом случае достигается теоретическая эффективность:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какая в этом случае достигается теоретическая эффективность:

Завершение вызова функции неблокирующего обмена приводит:

Среди предусмотренных в составе MPI операций передачи сообщений различают:

Длительность времени передачи одного слова данных по одному каналу передачи данных определяется:

Какие достоинства и недостатки имеет асинхронный механизм передачи сообщений?

К числу характеристик топологии сети передачи данных относятся:

Качество разрабатываемых параллельных методов определяется:

Как исключается неоднозначность вычислений в параллельном алгоритме метода сеток на системах с общей памятью?

Для определения угла поворота в рекурсивном инерционном методе деления пополам при решении задачи оптимального разделения графов, используется:

В отличие от геометрических схем комбинаторные методы решения задачи оптимального разделения графов не принимают во внимание:

В буферизованном режиме функция отправки сообщения завершается:

Для эффективного выполнения параллельного алгоритма умножения матрицы на вектор, основанного на блочном разделении матрицы, необходимо, чтобы процессоры вычислительной системы были объединены в топологию:

Рассмотрим задачу перемножения матриц. Пусть размер перемножаемой матрицы 200x200. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Кеннона, чему будет равна теоретическая эффективность при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Кеннона, чему будет равна теоретическая эффективность при использовании 4 процессоров:

Какие коммуникационные операции используются при выполнении параллельного алгоритма Кэннона?

Рассмотрим задачу поиска решения системы линейных уравнений. Размер матрицы системы линейных уравнений 10x10. На вычислительной системе все операции сложения и умножения выполняются одинаковое время  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какая в этом случае достигается теоретическая стоимость параллельного алгоритма:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какая в этом случае достигается теоретическая стоимость параллельного алгоритма:

В худшем случае трудоемкость быстрой сортировки оценивается выражением:

Метод бинарного деления для решения задачи оптимального разделения графов заключается:

. Пусть N = 4 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления:

. Пусть N = 4 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какое в этом случае достигается теоретическое ускорение:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какое в этом случае достигается теоретическое ускорение: . Пусть N = 8 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равна эффективность при использовании восьми вычислительных элементов:

. Пусть N = 8 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равна эффективность при использовании восьми вычислительных элементов: . Пусть N = 6 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равна стоимость вычислений при использовании восьми вычислительных элементов:

. Пусть N = 6 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равна стоимость вычислений при использовании восьми вычислительных элементов: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки, чему будет равна теоретическая стоимость при использовании 2 процессоров:

нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки, чему будет равна теоретическая стоимость при использовании 2 процессоров: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на блоки (количество блоков по строкам и по строкам равно и равно

нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на блоки (количество блоков по строкам и по строкам равно и равно  , где p – количество процессоров), чему будет равно теоретическое ускорение при использовании 16 процессоров:

, где p – количество процессоров), чему будет равно теоретическое ускорение при использовании 16 процессоров: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на ленты, чему будет равно теоретическое ускорение при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на ленты, чему будет равно теоретическое ускорение при использовании 4 процессоров: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Фокса, чему будет равна теоретическая эффективность при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Фокса, чему будет равна теоретическая эффективность при использовании 4 процессоров: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какая в этом случае достигается теоретическая эффективность:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какая в этом случае достигается теоретическая эффективность:  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какая в этом случае достигается теоретическая стоимость параллельного алгоритма:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какая в этом случае достигается теоретическая стоимость параллельного алгоритма:  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки чему будет равно теоретическое ускорение при использовании 2 процессоров:

нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки чему будет равно теоретическое ускорение при использовании 2 процессоров: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать алгоритм Кеннона, чему будет равно теоретическое ускорение при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать алгоритм Кеннона, чему будет равно теоретическое ускорение при использовании 4 процессоров: . Пусть N = 6 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равно ускорение при использовании неограниченного числа вычислительных элементов:

. Пусть N = 6 и применяется каскадная схема с минимально возможной высотой дерева модели вычисления. Чему в этом случае равно ускорение при использовании неограниченного числа вычислительных элементов: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на блоки (количество блоков по строкам и по строкам равно и равно

нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на блоки (количество блоков по строкам и по строкам равно и равно  , где p – количество процессоров), чему будет равно теоретическая эффективность при использовании 4 процессоров:

, где p – количество процессоров), чему будет равно теоретическая эффективность при использовании 4 процессоров: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки чему будет равно ускорение при использовании 4 процессоров:

нсек. Пропускная способность сети 60 Мбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на строки чему будет равно ускорение при использовании 4 процессоров: . Пусть N = 10 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления:

. Пусть N = 10 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какое в этом случае достигается теоретическое ускорение:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какое в этом случае достигается теоретическое ускорение: . Пусть N = 8 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления:

. Пусть N = 8 и применяется каскадная схема, аналогичная схеме описанной в лекции для суммирования элементов вектора. Какая в этом случае минимально возможная высота дерева модели вычисления: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Фокса, чему будет равно теоретическое ускорение при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Фокса, чему будет равно теоретическое ускорение при использовании 4 процессоров: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на ленты, чему будет равна теоретическая эффективность при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании использовать разделение матрицы на ленты, чему будет равна теоретическая эффективность при использовании 4 процессоров: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какая в этом случае достигается теоретическая эффективность:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и занимают w = 8 байт. Если при распараллеливании алгоритма сопряженных градиентов использовалось 4 процессора, то какая в этом случае достигается теоретическая эффективность:  нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Кеннона, чему будет равна теоретическая эффективность при использовании 4 процессоров:

Mбайт/сек. Элементы матрицы имеют тип double и занимают w = 8 байт. Если при распараллеливании использовать алгоритм Кеннона, чему будет равна теоретическая эффективность при использовании 4 процессоров: нсек. Латентности сети

нсек. Латентности сети  нсек. Пропускная способность сети

нсек. Пропускная способность сети  Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какая в этом случае достигается теоретическая стоимость параллельного алгоритма:

Mбайт/сек. Элементы матрицы системы линейных уравнений имеют тип double и в системе занимают w = 8 байт. Если при распараллеливании алгоритма Гауса использовалось 4 процессора, то какая в этом случае достигается теоретическая стоимость параллельного алгоритма: